- JASホーム

- JASジャーナル

- JASジャーナル2025年春号

- 標準化動向から読み解く放送の音の未来

JASジャーナル目次

2025spring

標準化動向から読み解く

放送の音の未来

NHK放送技術研究所

テレビ方式研究部

副部長 杉本岳大

概要

ラジオから始まった放送にとって、音は欠くことのできない情報伝達手段です。本稿では、近年、オリンピックの番組制作などでも使用され、普及が進んでいるオブジェクトベース音響方式および、近年ゲームや標準化の分野で注目が集まる、視聴者の自由な行動に追従できるsix-degree of freedom(6DoF)音響方式に着目し、放送の音の未来について考えます。

1. はじめに

日本のデジタル放送は、2000年のBSデジタル放送を皮切りに、その後の地上デジタル放送、新4K8K衛星放送と発展を続け、はや四半世紀が経過しています。では次の10年後、次の四半世紀後には、どんな放送サービスが実現されているのでしょうか。本稿では、放送サービスの実用化に欠かすことのできない標準化動向を軸にして、今後の放送の音の方向性について思いを巡らせてみます。

2. 放送の音と標準化の関係

日本のデジタル放送では、すべてのテレビ受信機で番組を視聴できるように、映像や音声、伝送などの技術方式が標準化されており、これらの技術方式に基づいて、番組が制作され放送されています。また、これらの技術方式の多くは、国際的な標準規格を採用しています。これによって、海外の放送局との番組交換や共同制作が容易になるとともに、放送機器や受信機のコストの低廉化も期待できます。

放送に用いる音の技術も、技術開発と標準化の両輪の上に発展してきました。2000年開始のBSデジタル放送の音響システムに5.1サラウンドが採用されたのに続き、2003年開始の地上デジタル放送でも5.1サラウンドが採用されました。さらに、2018年開始の新4K8K衛星放送では、視聴者の上層・下層にもチャンネルを配置した、22.2マルチチャンネル(22.2ch)音響システムが採用されました。これらは、過去に様々な標準化機関で標準化されてきた音響システムです。

そこで本稿では、次世代の放送で期待されている音の最新の技術と、国際標準化の動向についてご紹介します。放送の音に関連する国際標準化機関は幾つも存在しますが、特に関連の深い機関としてITU-R(International Telecommunication Union-Radiocommunication Sector)とMPEG(Moving Picture Experts Group)があります。ITU-Rにおいて放送業務を扱う第6研究委員会(SG6)に設置されている、番組制作および品質評価を担当する作業部会(WP6C)は、主に番組制作に関連する技術を標準化しています。またMPEGは音声符号化方式に関連する技術の標準化を所掌しています。第3章で紹介するオブジェクトベース音響方式(object-based audio:OBA)はこれまで主にITU-RのSG6で標準化され、第4章で紹介するsix-degree of freedom(6DoF)音響方式は現在MPEGで標準化が進んでいます。次章からは、特にOBAと6DoF音響方式に絞って、サービスイメージや技術内容を紹介します。

3. オブジェクトベース音響方式

番組の音を自由にカスタマイズできることは、視聴者からの長年のリクエストでした。特にセリフやナレーションの聞き取り易さに関しては、現在も多くの要望が寄せられています。音声の聞き取り易さというと、まずナレーションと背景音のミキシングバランスに原因を求めたくなります。ところが、視聴者のミキシングバランスに対する好みは千差万別で、一種類のミキシングバランスでは全ての視聴者を満足させられないことが、調査の結果、明らかになっています[2]。ミキシングバランスの好みの違いが生じる要因は、再生装置の性能や再生音量、聴取環境の違いや個々人の聴力、さらには番組内容に対する親密度など多岐にわたると想像されます。

現在の放送で採用されている音響方式はチャンネルベース音響方式(channel-based audio:CBA)[3]です。CBAは、番組を構成する各音声信号と、ターゲットとなるスピーカー配置(22.2ch音響システム、5.1サラウンド、ステレオなど)の各チャンネルとが、一対一に関連付けられることを特徴とする音響方式です。CBAによる番組制作では、制作時に各音素材 1のミキシングパラメーター(レベルや定位など)を決定し、スピーカー配置に合わせて音素材をミックスします。番組音声は、使用された音素材の多寡にかかわらず、ステレオなら2チャンネル分、5.1サラウンドなら6チャンネル分と、決められた数の音声信号にまとめ上げられることになります。CBAは、視聴者が制作時と同じスピーカー配置で聴取することを前提としているため、番組制作者にとっては番組の品質管理がしやすい方式と言えます。ただし、仕組みから明らかなように、視聴者はスタジオでミックスされた音声をそのまま聴取することが原則で、ミキシングパラメーターを操作して個人の好みを反映させることはできません。料理に喩えるなら、味付けも含めて調理が完成した状態です。

一方、次世代の放送において番組の音を視聴者が自由にカスタマイズできることを目的に、OBAが開発・標準化されてきました [3]。OBAは、音声信号と音響メタデータ 2の組み合わせである音声オブジェクトを、レンダラーが番組として再構成(レンダリング)し、再生する音響方式です。

- 1 声や楽器・効果音など、番組制作に用いる音の材料となる音声信号。

- 2 再生時の音声オブジェクトの役割や組み合わせ、音声信号の位置・レベルなどに関する付属情報を指します。国際的に普及しているものの一つとして、Audio definition model(勧告ITU-R BS.2076)があります。

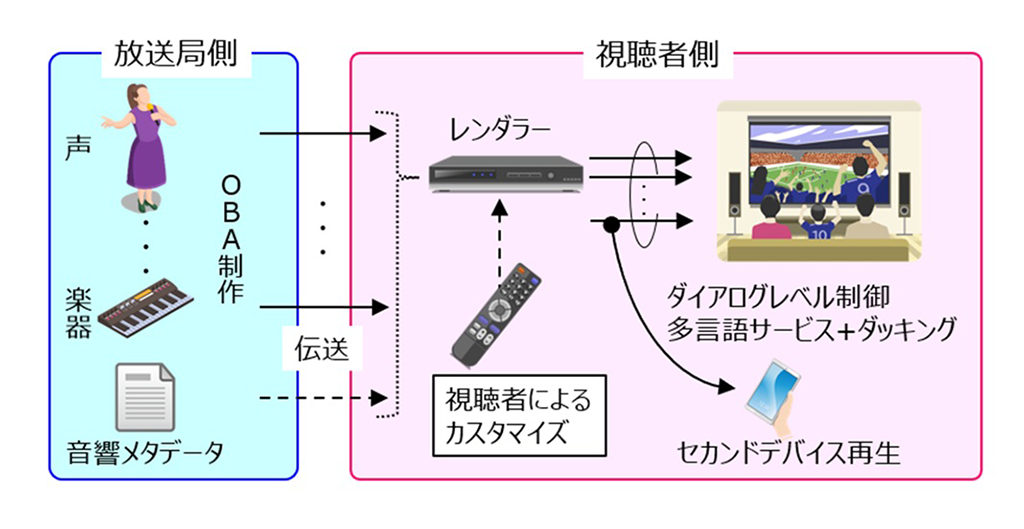

図①にOBAの概念図を示します。レンダラーの役割は、音響メタデータで記述された番組の構成、言い換えれば番組の設計図の解読と、指定されたレベル、かつ適切なスピーカーへの各音声信号の分配・再生です。図①に示したように、OBAではCBAのようにミキシングを放送局側で完成させず、音素材のまま伝送することで、視聴者側のレンダラーでミキシングが完成する点が大きな特徴です。

この仕組みのメリットを直感的に伝えるために、ここでまた料理に喩えてみましょう。音素材がミックスされずに視聴者側まで伝送されるということは、各食材が調理されずに(もしくは途中まで調理されて)各家庭に届く食材宅配サービスになぞらえることができます。料理の大きな方向性、つまり出来上がる料理名は変わらないとしても、調理する人の好みに合わせた味付けができる余地があるわけです。ミキシングの一部を視聴者に委ねることで番組音をカスタマイズできる点がCBAにはないOBAの特徴であり、音素材の宅配サービスと言うこともできるでしょう。

このようなOBAの特徴を活かしたサービスとして、これまで検討されてきた例を挙げてみます。

- ダイアログレベル制御:セリフやナレーションの音量だけを、音楽などの背景音とは別に増減する機能。聞き取りの改善だけでなく、解説音声を消してスポーツ観戦に没入する使い方も可能

- 多言語サービス:セリフやナレーションを好みの言語に差し替えて再生する機能。

- ダッキング:セリフやナレーションの発話タイミングに合わせた、背景音の音量を適応的に調節する機能

- セカンドデバイス再生:テレビで流れているセリフやナレーション、解説とは異なる内容の音声を、スマホなどの手元のデバイスで再生する機能

なおこれらの機能においては、カスタマイズの範囲を番組制作者が設定することもできます。例えば、番組Aではセリフの音量を下げる方向しか許容しない、番組Bではセリフの音量の増加を+6dBまで許容する、のような設定です。このような設定により、番組の制作意図を大きく損なうようなカスタマイズを避けることができます。図②にOBA番組の操作のGUI例を示します。

ここまで機能性の話ばかりで、臨場感の向上についての言及がないことに疑問を抱く方がいるかもしれません。誤解されがちなのですが、臨場感はスピーカー数が増えることによって向上する聴感印象です[4]。OBAは家庭のスピーカー配置に合わせてレンダリングを最適化する機能があるものの、CBAと同じく、設置されたスピーカー以外の場所から音を再生することはできません。臨場感はOBAもCBAもスピーカー配置に依存するものであり、OBAの採用と臨場感の向上との間には、直接的な関係はないと言えるでしょう。

OBAを放送で使用するためには、OBAに対応した音声符号化方式の採用も必要になります。国内では、衛星放送と地上放送の技術方式は、(一社)電波産業会(ARIB)で標準化されています。日本の次世代の地上デジタル放送方式については、2023年の情報通信審議会の答申の後、省令・告示の公布・施行を経てARIBで標準規格(STD)が策定され、OBAを扱える音声符号化方式としてMPEG-H 3D audioとAC-4がARIB STD-B32に採用されました[5]。韓国では既にMPEG-H 3D audioによる放送が開始され、欧米で標準化された次世代放送方式であるDVB (Digital Video Broadcasting)-T2やATSC (Advanced Television Systems Committee) 3.0でもOBA対応の音声符号化方式が採用されています。またブラジルでもMPEG-H 3D audioによる放送が実用段階に入りつつあります。さらに近年のオリンピックでは、OBAで番組制作される機会が増えています。日本国内においても、OBAを用いた利便性の高い放送の実現が待たれます。

4. 6DoF音響方式

NHK放送技術研究所では、その場にいるかのように仮想空間を体感するための次世代メディアを目指し、イマーシブメディアの研究・開発を進めています[6]。イマーシブメディアは、これまでのメディアでは体験できなかった実物感・没入感の提供に向けて、AR(Augmented Realty)グラスやVR(Virtual Reality)用ヘッドマウントディスプレイなどの没入型デバイスを積極的に活用するとともに、スマートフォンやタブレットなどの従来デバイスへのコンテンツ提示も可能な仕組みを目指しています。

イマーシブメディアの音響技術は、仮想空間における視聴者の自由な行動、すなわち6DoFをサポートする必要があります(本稿では、6DoF音響方式と呼びます)。ここで、three-degree of freedom (3DoF)音響方式と6DoF音響方式を比較してみましょう(図③)。22.2ch音響システムを始めとした従来の3次元音響システムは、固定の聴取位置における回転のみに対応する3DoF音響方式です。3DoF対応と言っても、多くのコンテンツはテレビや映画のように視聴者の前方に映像を伴う前提ですから[7]、側方や後方を向いての聴取も物理的には可能というだけで、積極的に推奨される聴取スタイルではありません。

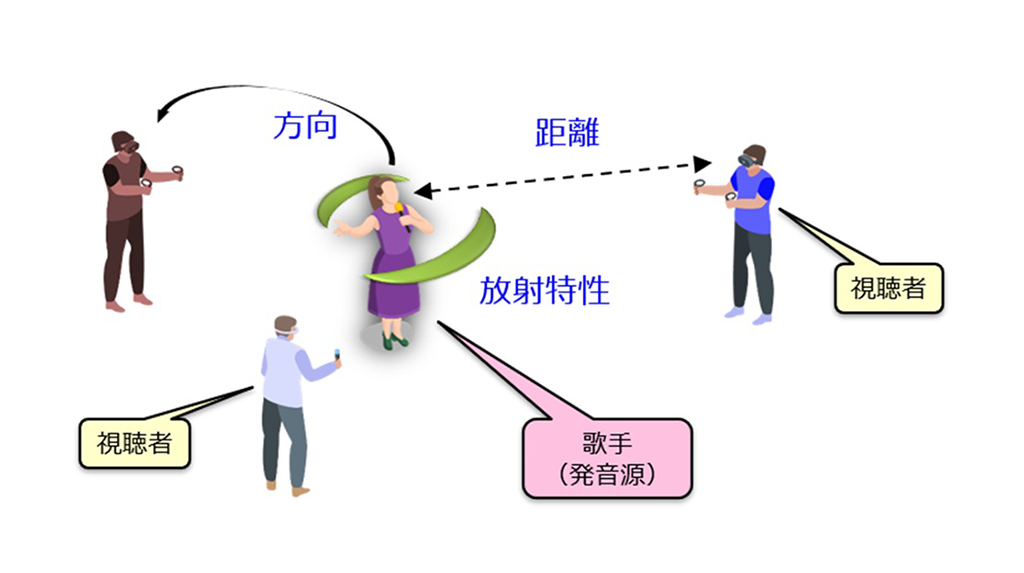

一方、6DoF音響方式の特徴は、視聴者の移動に伴って歌手や楽器などの発音源との位置・向きの関係が変化し、それに合わせて再生音が変化する点です。視聴者の移動に再生音を追随させるためには、視聴者と発音源との幾何学的な関係を逐次更新する必要があるのですが、そこで活躍するのが3章で触れた音響メタデータです。音響メタデータに仮想空間内の各発音源の位置や向き、放射特性やレベルなどを記載しておけば、仮想空間内の視聴者の位置での音の状態を決定できるのです。ここで、6DoF音響方式における発音源のレンダリング要素を示します(図④)。

- 方向:視聴者の位置・向きを基準とした場合の、発音源の方向

- 放射特性: 発音源の位置・向きを基準とした場合の、視聴者の方向に対応する放射音の音響特性。例えば、発音源の音声信号に重畳するための、放射方向に応じて変化する周波数特性として表現する

- 距離: 発音源の基準位置から視聴者までの距離。発音源の音声信号の再生レベルに対して、距離に応じた減衰分を反映

図⑤に、6DoF音響コンテンツの展示の様子を示します。実空間に配置した各キャラクターのパネルと、音の仮想空間を重ね合わせることで、キャラクターに近づくとそれぞれの会話がヘッドホンから聞こえてくる仕掛けになっています。

また仮想空間は、図④に記載したような見通しのよい空間ばかりではありません。そこで、音の伝播に影響する、壁や柱などの障害物が存在する空間では、前記のレンダリング要素に加え、室内音響に関連する以下の要素も考慮することになります(図⑥)。

- 反射:板などによる伝播音の反射。吸音も表現可能

- 遮蔽:壁や床・天井などによる伝播音の遮蔽

- 回折:経路上の物体における伝播音の回り込み

- 残響:室の音響特性に応じた残響成分の付加。例えば、初期反射と後部残響の組み合わせで表現する

このように、レンダリング時に考慮すべき物理現象を増やしていくと、6DoF音響用のレンダラーは、最終的には室内音響シミュレーターに近づいていきます。AR・VR用の音響規格であるMPEG-I Immersive audio [8]でも、複雑な音響事象を取り扱える室内音響シミュレーターのようなレンダラーの標準化が進んでいます。

一方で、番組の演出によっては、無視しても構わない音響事象・むしろ無視した方が都合の良い音響事象も出てくるでしょう。特徴的な例として、宇宙空間を遊泳できる番組を考えてみます。真空中に音は存在しないから全編無音で制作という方針を取ると、実際はそうであっても奇妙な番組になってしまうかもしれません。したがって、番組としての仮想空間は、必ずしも実空間の物理法則通りに構成されている必要はありません[9]。このような柔軟な解釈・デフォルメは、従来の番組制作においても長年蓄積されてきた制作手法です。

6DoF音響方式は、ゲーム業界では既に実用化・商用化が進んでいます。PlayStation VR2やSteamVRでは継続的にVRデバイス対応の新タイトルが発売されています。ゲームにおいては、基本的にプレイヤーが仮想空間の主人公になり切る設定が多いため、1人称での視聴体験になります。しかし従来の放送番組のコンテキストにおいて1人称はどちらかと言えば特殊なケースであり、3人称での俯瞰が常道です。6DoF音響方式の今後は、先行するゲームでの実用化事例も参考にしながら、放送番組ならではの応用を考えていくことになるでしょう。

5. まとめ

本稿では、音響技術に関する標準化動向を参考にして、OBAおよび6DoF音響方式に着目し、技術内容やサービスイメージを紹介しました。放送の音の未来は、一人一人の視聴者に合わせてより特別なメディア体験を提供できるサービスに向かっていくでしょう。この小文がきっかけとなって放送の音に興味を持っていただけたのなら、望外の喜びです。今後の進展にご期待ください!

参考文献

- [1] 鎌本優, 原田登, 守谷健弘, 「標準化のお作法—標準化の例と関連する仕事—」, 日本音響学会誌77巻2号, pp. 128-134 (2021).

- [2] T. Sugimoto, Y. Nakayama, T. Komori, T. Chinen, and M. Hatanaka, “Dialogue channel control for 22.2 multichannel sound broadcasting: Broadcast chain scheme and subjective evaluation of effectiveness,” J. Audio Eng. Soc. Vol. 65, No. 6, pp. 507-516 (2017). ↑

- [3] 杉本岳大,「音響規格における音響方式の位置づけ ―チャネルベース・オブジェクトベース・シーンベースの3音響方式―」,日本音響学会誌80巻12号, pp. 675-683(2024). ↑ ↑

- [4] M. Schoeffler, A. Silzle, and J. Herre, ‘‘Evaluation of spatial/3D audio: Basic audio quality versus quality of experience,’’ IEEE J. Sel. Top. Signal Process., Vol. 11, pp. 75-88 (2017). ↑

- [5] 浦野丈治, 中山靖茂, 「地上デジタル放送の高度化に係わる音声符号化方式」, JAS J. Vol. 63, No. 2 (2024) ↑

- [6] NHK放送技術研究所, 「Future Vision 2030-2040」 (2024) ↑

- [7] Recommendation ITU-R BS.1909-1, “Performance requirements for an advanced sound system for use with or without accompanying picture,” International Telecommunication Union (2023). ↑

- [8] ISO/IEC 23090-4, “Information technology —Coded representation of immersive media — Part 4: MPEG-I Immersive audio” (under standardization). ↑

- [9] T. Sugimoto, T. Hasegawa, T. Iwasaki, H. Kubo, S. Oode, and H. Okubo, “Requirements for 6DoF audio service and 6DoF audio metadata,” 2023 AES Intl. Conf. on Spatial and Immersive Audio, Conference paper 33 (Huddersfield, August 23-25, 2023). ↑

執筆者プロフィール

- 杉本岳大(すぎもと たけひろ)

2001 年、東京大学大学院工学系研究科修士課程修了。同年NHK入局。放送技術研究所にて音響トランスデューサ、音声符号化、3次元音響、6DoF音響の研究およびMPEG、ARIBの標準化活動に従事。博士(工学)、AES Fellow。趣味は必ずしも聴くことが目的ではないCDを収集すること。特技は試聴せずにスペックシートだけでオーディオ機器を選ぶこと。